2024是AI MCU元年?

发布日期:2025-01-16

点击次数:168

人工智能(AI)和机器学习(ML)技术曾经是大型数据中心和强大GPU的代名词,而正致力于实现网络边缘推进,并立足于微控制器(MCU)等资源构成的组件中。2024年近年来,越来越多高效的MCU工作负载与AI功能相结合,在嵌入式系统中实现音频处理、计算机视觉、声音分析和其他算法等各种定制应用。

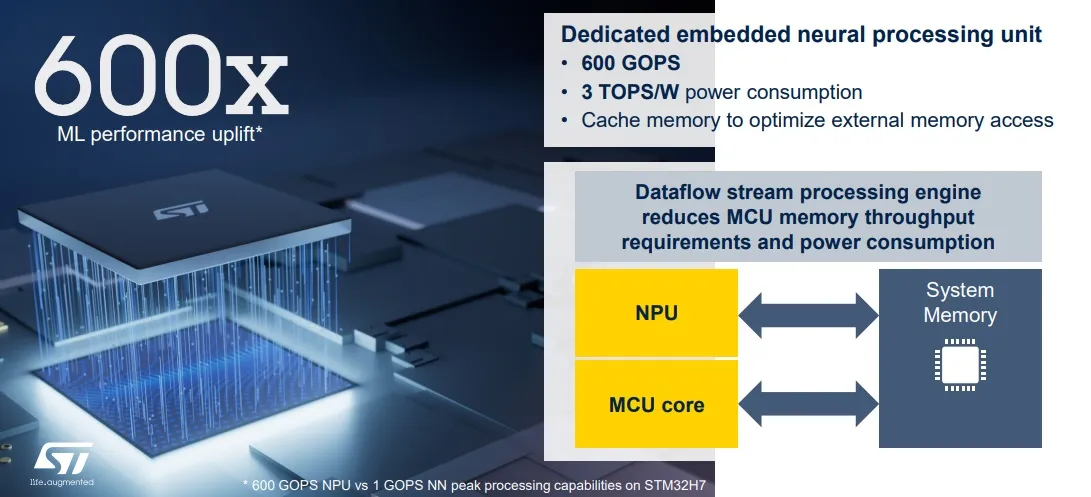

以ST(意法半导体)及其STM32N6 MCU为例,它配备了专用于嵌入式推理的神经处理单元(NPU),可以说是ST功能最强大的MCU。此外,还可以执行分割、分类除了这款 MCU 之外,ST 还提供了软件和工具,帮助开发人员降低入门门槛,让他们能够在实时操作系统 (RTOS) 中充分利用 AI 加速性能。

图1:STM32N6的Neural-ART加速器可提供比恐慌高端STM32 MCU高600倍的ML性能。(来源:意法半导体)

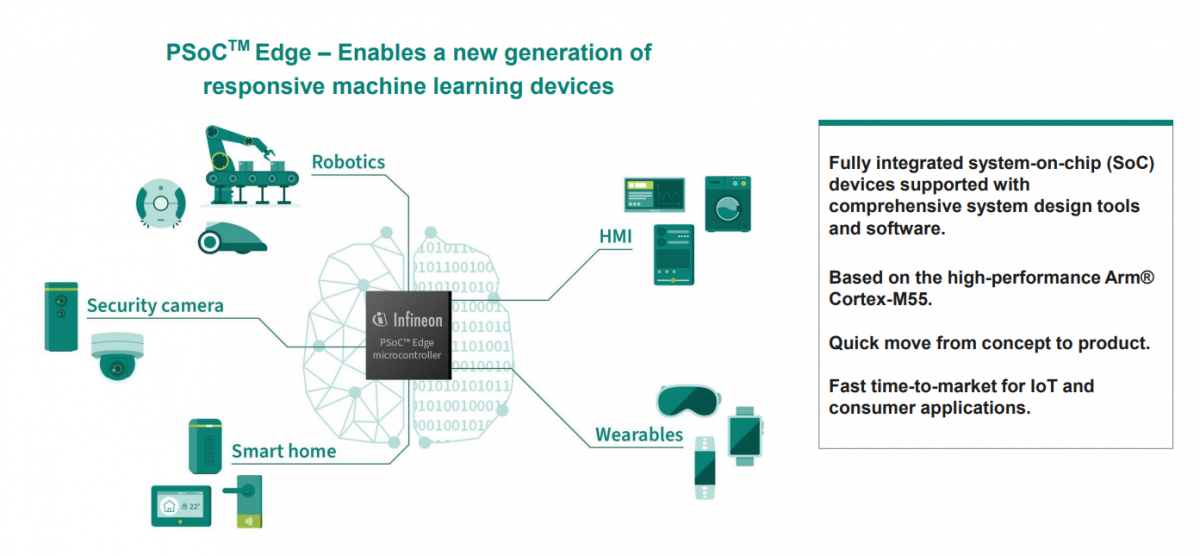

另一家领先的MCU供应商英飞凌也在其PSOC MCU系列中集成了硬件加速器。其NNlite神经网络加速器的目标推动以ML为基础的新型应用,例如唤醒、基于视觉的位置检测,以及面部识别部/对象识别等,头部消费、工业以及物联网(IoT)等应用领域。

图2:PSoC Edge系列MCU集成NNlite神经网络加速器,实现以ML为基础的新一代应用。(来源:英飞凌)

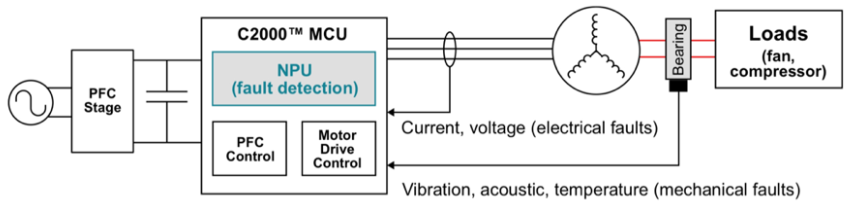

TI(德州仪器)则将其支持AI的MCU称为实时微控制器,并在其C2000设备内部集成了一个NPU,以实现高精度、低延迟的故障检测。这可以让嵌入式应用实时做出精确的智能决策,以执行太阳能和储能系统中的电气故障检测,以及用于预测性维护的电机轴承故障检测等功能。

图3:C2000 MCU集成了Edge AI硬件加速器,实现更智能的实时控制。(来源:TI)

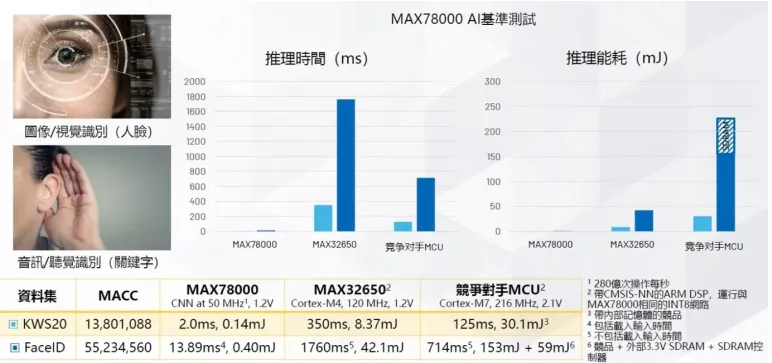

事实上,ADI更早之前即在其硬件与平台堆栈的基础上集成具有智能、安全与超低功耗(ULP)优势的Maxim MCU,推出了新一代AI MCU MAX78000,基于硬件的神经网络(CNN) 加速器,只需消耗微焦耳的能量即可执行 AI 推理,性能更高的 Edge AI MCU 系列支持复杂的睡眠、指纹识别、指纹分析和物体检测等视觉和推理应用。

图4:近期于其他解决方案,AI MCU 执行 AI 推理的速度更快、功耗支出。(来源:ADI)

在这些AI MCU上执行的模型,可通过训练来学习和适应不同的环境,这反过来又有助于系统实现超过99%的故障检测准确率,从而实现更明智的边缘决策。此外,预先模型的可用性进一步降低了在训练中 MCU 上执行 AI 应用的能力。

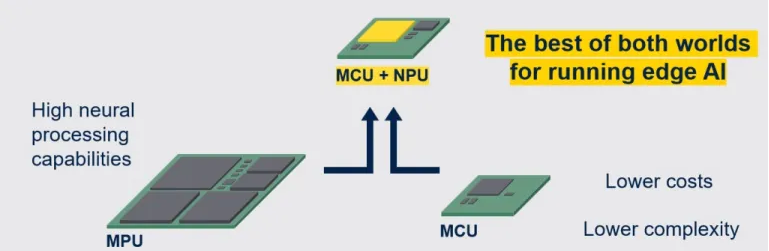

更重要的是,在MCU内部加入硬件加速器,可以减弱主显卡的推理工作负载,释放更多的时钟周期用于嵌入式应用。这与AI硬件加速MCU进程的开始。在这一旅程的开始起点,将会把MCU推向以往需要MPU的应用领域。在嵌入式设计领域,MPU也能完全具备实时控制设计任务的能力。

随着MCU的性能持续发展,MCU与MPU之间的界限将变得更加模糊,越来越多适合资源架构的神经网络模型将出现在MCU+AI的应用上,这不仅让MCU变得更加模糊性价比的解决方案,也有利于MCU行业迎接新的应用和厂商。

图5:支持AI的MCU将在多种嵌入式系统设计中取代MPU,另外为半导体产业带来重大的变革与冲击。(来源:意法半导体)

无疑,AI是MCU演进的下一个重大方向,但针对AI优化的MCU还有很长的路要走。例如,软件工具及其易用性将必须与这些AI MCU齐头并进,才能帮助开发人员评估AI模型在MCU上的可嵌入性。另外,开发人员也应该能够只需简单点击几下,就可以快速测试在MCU上执行的AI模型。

2024年开启了MCU领域的AI时代,到了2025年,我们很可能见证更多轻量化AI模型在MCU上的进一步突破。

声明:

本文来源于网络 ,如有问题请联系,谢谢

宏熙半导体(无锡)有限公司http://www.hongximos.com